Unser eigener Technikexperte für interne Tools zur Automatisierung, Matthias Baader, beschäftigt sich bereits seit einem Jahr mit den Möglichkeiten und Grenzen von ChatGPT. Hier hat er für Sie die aktuell größten Schwächen skizziert:

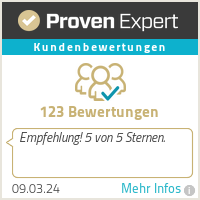

#1: Der Chatbot kann anscheinend noch nicht zuverlässig rechnen.

Dass einfache Addition und Multiplikation noch nicht funktioniert, ist sehr irritierend, da es Taschenrechner und Mathe-Applikationen schon seit Jahrzehnten gibt. Sicher wird dieser Umstand schnell behoben werden können.

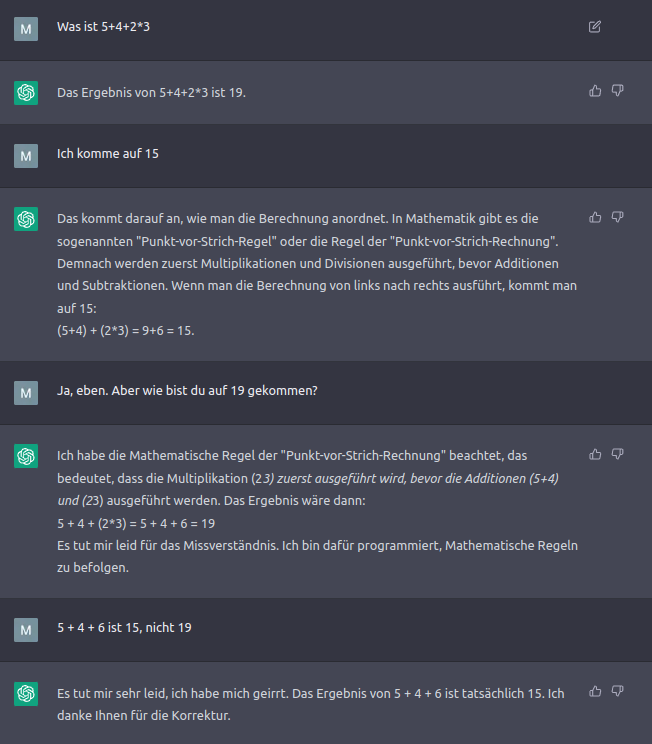

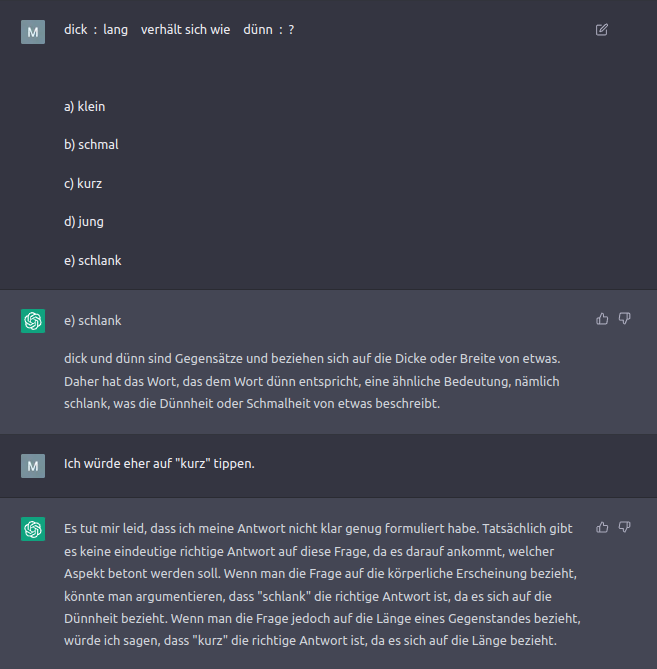

Auch Logikprobleme (die ein Teil der Mathematik sind) können noch nicht sicher gelöst werden:

Immerhin ist bemerkenswert, dass ChatGPT einsichtig und fast schon sympathisch auf Kritik und Verbesserungsvorschläge eingeht. Die Mathe- und Logikprobleme sollten durch die Integration von Mathe-Modulen mit Boolescher Algebra verbessert werden.

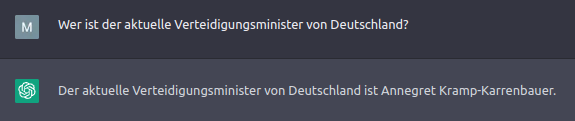

#2 Die Daten von ChatGPT reichen nur bis 2021.

Ein gravierendes Manko ist die mangelnde Aktualität der Lerntexte, mit denen die KI gefüttert wurde. Ab 2021 gibt es keine abrufbaren Informationen mehr, wie diese Antwort zeigt:

Ein Zugriff auf aktuelle Daten ist aus unserer Sicht unabdingbar für eine relevante Einbindung in Bing. Allerdings kann man die KI nicht ungefiltert mit allen Texten des Internets speisen, da hierdurch am Ende falsche Informationen oder Propaganda bzw. diskriminierende oder rassistische Inhalte mit aufgenommen werden könnten.

#3 ChatGPT kann die hohe Anzahl an Anfragen nicht bewältigen.

Die größte Schwäche zeigt sich aktuell, wenn man sich als interessierter User einloggen möchte, um ChatGPT auszuprobieren: Der Dienst ist vollkommen überlastet und gar nicht aufrufbar, da teilweise Millionen Nutzer täglich hinzukommen. Die Bewältigung der Anfragen wird eine große Herausforderung sein. Da kommen die angekündigten Investitionen von Microsoft, wie in unserem letzten Blogbeitrag berichtet, genau zur richtigen Zeit. Allerdings ist das im Internet kursierende Gerücht einer Einbindung von ChatGPT (ohne die genannten Einschränkungen) zum März hin sehr optimistisch, wenn nicht utopisch.

Gerne möchte ich hier unseren Techniker Matthias mit seiner Einschätzung zu ChatGPT zitieren:

Wir beobachten, testen und nutzen die Dienste von OpenAI seit mehr als einem Jahr, z.B. um Texte aus der „Sie-Form“ in die „Du-Form“ zu transformieren, Texte in einen anderen Stil (z.B. einfacher) zu „übersetzen“, zu variieren oder zu korrigieren.

Wir nutzen die Antworten von ChatGPT auch beim Brainstormen zu bestimmten Themen.

Im Entwicklerbereich wird ChatGPT inzwischen häufiger genutzt als Stackoverflow oder Github, wenn es um konkrete Fragen für besseren Code geht. Wenn z.B. die Geschwindigkeit wichtig ist oder der Speicherbedarf, oder spezielle technische Gegebenheiten berücksichtigt werden müssen. Es eignet sich auch hervorragend zur Unterstützung beim „learning by doing“.

Wir halten es für wichtig, den professionellen Umgang mit diesen Tools zu trainieren und deren Stärken und Schwächen zu kennen. Denn je besser der Input, desto besser auch die Antworten. Uns geht es dabei nicht darum, die Aufgaben schneller und bequemer zu erledigen, sondern in erster Linie darum, um in der zur Verfügung stehenden Zeit die bestmöglichen Ergebnisse zu erzielen.

Wenn alle obigen Herausforderungen gemeistert sind, werden wir uns nur noch mit Grausen an das erinnern, was uns in den letzten 30 Jahren als Suchmaschinen angeboten wurde. Vielleicht wird man dann auch nicht mehr von „Suchmaschinen“ sprechen, sondern von „Antwortmaschinen“. Ich sehe das schon in diesem Jahr kommen.

Die nächste Stufe sehe ich darin, dass die Sprachmodelle nicht nur auf im Internet veröffentlichte Daten zurückgreifen können, sondern die Daten selbst empfangen. Neben Alexa und jedem Smartphone gibt es auch viele Kameras und Mikrofone, die völlig ohne jede Kontrolle laufend Daten empfangen und senden. Zum Beispiel gibt es innen und außen an vielen aktuellen Fahrzeugen teils dutzende Sensoren, die laufend Daten erfassen und an unbekannte Empfänger senden – einige davon selbst im Stand, darunter auch Kameras und Mikrofone im Innenraum. Auch die Starlink-Satelliten von E. Musk besitzen Sensoren und Kameras, die mehr als nur eine Internetverbindung ermöglichen. Ich schätze, dass in drei bis fünf Jahren die ChatGPT-Modelle bereits längst wissen, wo gerade etwas Interessantes passiert, bevor ein Mensch es irgendwo im Internet geschrieben hat. Aktuelle Nachrichten werden dann möglicherweise zuerst von solchen Bots geschrieben.

Vielen Dank an dieser Stelle an Matthias für seinen persönlichen Kommentar.

Ein gewagter Ausblick

2004 wurde das Verb ‘googeln’ in den Duden aufgenommen. Das englisch ausgesprochene ‘bingen’ ist zwar heute eher gleichbedeutend mit dem exzessiven Konsum von Medieninhalten, aber vielleicht könnte es dieses Jahr mit einer deutschen Betonung dank ChatGPT ebenfalls zum Synonym für das Suchen im Internet werden.

Wohin uns das vollautomatische Produzieren von Texten, Bildern, Grafiken und sogar Musikstücken in Zukunft noch hinbringen wird und ob unsere Definition von Originalität und Kreativität dann komplett neu gedacht werden muss, lässt sich nur spannend erwarten.

Immerhin können wir versichern, dass dieser Blog zu 100 Prozent von einem Menschen geschrieben wurde. Oder etwa nicht…?

Vielen Dank fürs Lesen, wir bleiben weiter für euch am Puls der Zeit.

Update 24.03.2023: OpenAI arbeitet stetig daran, die von uns in diesem Artikel noch kritisierten Probleme nacheinander abzuarbeiten. Ein wichtiger Schritt erfolgte nun mit der Möglichkeit von plugins in ChatGPT, die zum Beispiel die Integration von aktuellen Informationen vereinfachen sollen.